本篇文章不是特别完整,所以放上在公司做的内部分享的PPT。

SSAO标签: Unity3D

C#代码:

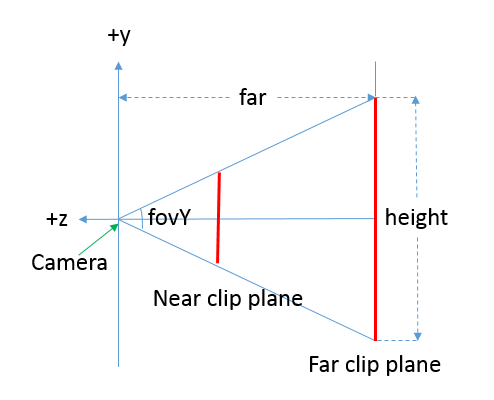

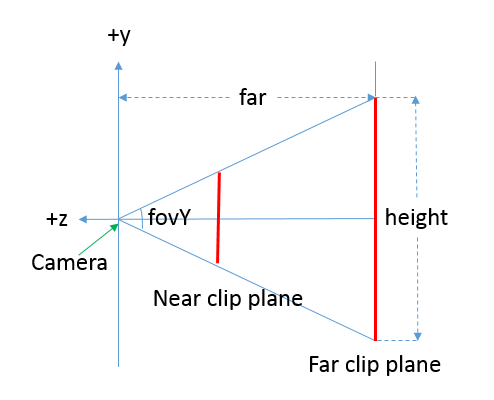

float fovY = m_Camera.fieldOfView;

float far = m_Camera.farClipPlane;

float height = 2 * Mathf.Tan(fovY * Mathf.Deg2Rad * 0.5f) * far;

float width = height * m_Camera.aspect;

m_Material.SetVector("_FarCorner", new Vector3(width, height, far));

上面的代码主要是求得远裁剪平面的宽、高,以及距离摄像机的距离。都是以摄像机空间的单位为单位的,而不是以像素为单位(Camera.pixelWidth, Camera.pixelHeight)。

shader代码:

float depth = Linear01Depth(tex2D(_CameraDepthTexture, uv).x); float3 ray = (half3(-0.5f,-0.5f,0) + half3(uv.xy,-1)) * _FarCorner; float3 viewPos = ray * depth;

tex2D(_CameraDepthTexture, uv).x根据屏幕像素的uv对深度纹理进行采样获取Z buffer,但此时的Z buffer是非线性的,需要调用Linear01Depth将其映射到线性的[0, 1]区间内,0对应摄像机位置,1对应远裁剪平面。

half3(-0.5f,-0.5f,0) + half3(uv.xy,-1)将uv坐标减去0.5,从[0,1]区间映射到了[-0.5,0.5]区间。

乘以_FarCorner得到half3((uv.x - 0.5f) * width, (uv.y - 0.5f) * width, -1 * far),此时x在[-0.5width, 0.5width]区间内,y在[-0.5height, 0.5height]区间内,z是-far。

但以上只是远裁剪平面的情况,实际上每个xy平面的宽高以及对应的z值是随depth线性变化的。所以最后一步乘以depth,获得最终的摄像机空间下的坐标。

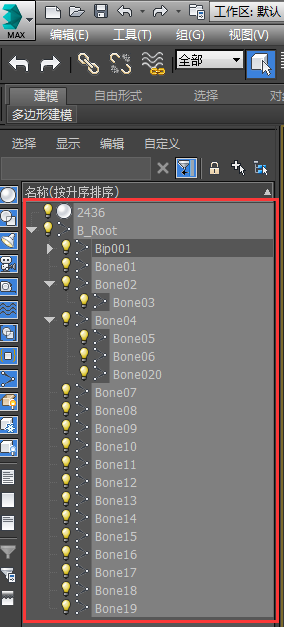

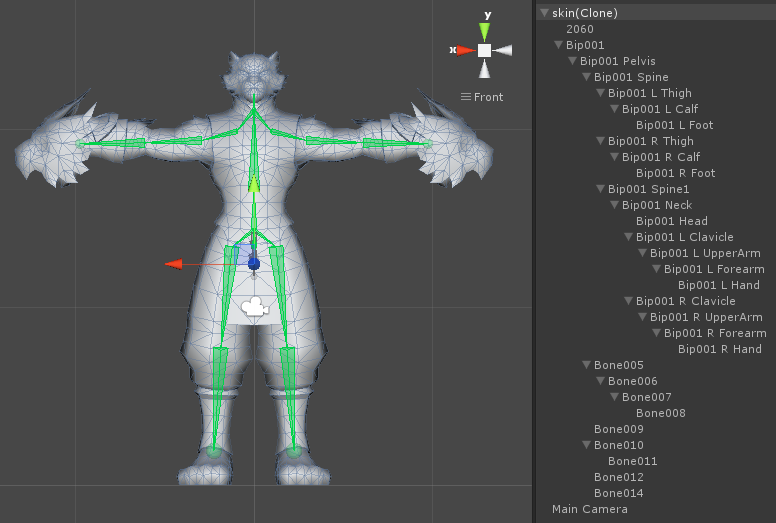

我们游戏内的动作都是Generic类型的,并且技能动作使用了{% post_link Unity-Root-Motion Root Motion %}来处理技能位移。

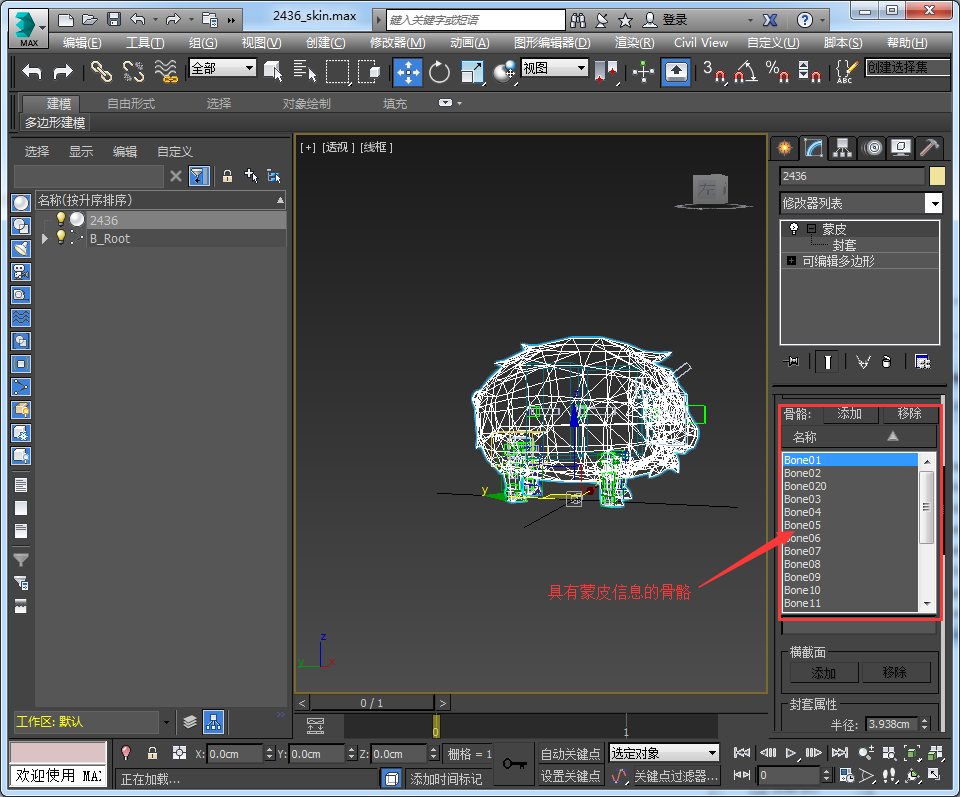

所有模型都有一跟B_Root骨骼(没有蒙皮信息),用作模型导入设置里的Root node。

如果将动作类型改为Humanoid,则由于B_Root的存在,会导致Root Motion无法正常使用,不管Bake Inot Pos与否,动作本身都会有位移,看表现应该是B_Root影响到了Body Transform和Body Orientation的计算: